Neurociencias

El cerebro humano puede almacenar 10 veces más información de lo que se pensaba hasta hoy

Logran medir con mayor precisión la fuerza y la plasticidad de las sinapsis, que permiten la comunicación neuronal

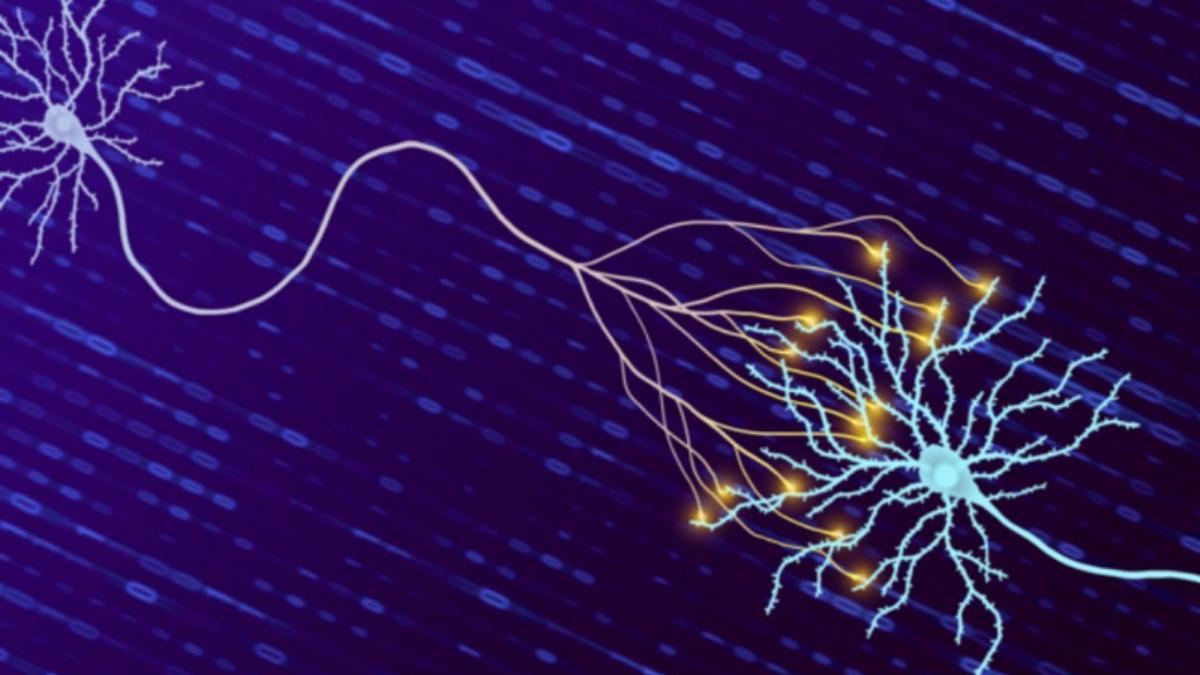

La neurona de la izquierda envía mensajes a la neurona de la derecha. El pulso eléctrico de las sinapsis que procesan y envían información está representado por destellos amarillos. / Crédito: Instituto Salk.

Pablo Javier Piacente

Los investigadores aprovecharon un nuevo método para medir con exactitud la cantidad de información que el cerebro puede almacenar: descubrieron que puede resguardar casi 10 veces más datos de aquello que se suponía hasta el momento. Los hallazgos, que mejoran notablemente el análisis de las sinapsis, que integran a las neuronas y posibilitan su trabajo en red, permiten avanzar en la comprensión de procesos como el aprendizaje y la memoria y en la forma en que estos son afectados por el envejecimiento y las enfermedades.

Científicos del Instituto Salk, en Estados Unidos, han publicado un nuevo estudio en la revista Neural Computation en el que concluyen que nuestro cerebro posee una mayor capacidad para almacenar información con respecto a la indicada por investigaciones previas: en concreto, podría registrar 10 veces más datos. La investigación logró incrementar la exactitud en la forma de medir la potencia de las sinapsis, que conectan a las neuronas entre sí y hacen posible las funciones cerebrales más complejas.

Las sinapsis y los procesos cerebrales

Los recuerdos que construyen nuestra memoria y los nuevos conocimientos que se gestionan y acumulan mediante el aprendizaje son parte de procesos vitales en el cerebro humano, que sufren modificaciones con el paso del tiempo, pueden verse afectados por distintas patologías o, incluso, logran potenciarse a través de algunas prácticas y hábitos. Son posibles mediante conexiones neuronales, llamadas sinapsis, que pueden fortalecerse o debilitarse ante determinadas situaciones, una característica conocida como plasticidad sináptica.

"Estamos mejorando en la identificación exacta de dónde y cómo se conectan las neuronas individuales entre sí, pero todavía tenemos mucho que aprender sobre la dinámica de esas conexiones. Ahora hemos creado una técnica para estudiar la fuerza de las sinapsis, la precisión con la que las neuronas modulan esa fuerza y la cantidad de información que las sinapsis son capaces de almacenar. Esto nos llevó a descubrir que nuestro cerebro puede almacenar 10 veces más información de la que pensábamos anteriormente”, indicó en una nota de prensa el científico Terrence Sejnowski, autor principal del nuevo estudio.

Una técnica que permite avanzar en la comprensión del cerebro humano

Según informa Live Science, los científicos pudieron precisar que cada sinapsis logra acumular entre 4.1 y 4.6 bits de información. Este nuevo enfoque, que utiliza la teoría de la información, ha obtenido un resultado que representa 10 veces más almacenamiento de información en el cerebro de lo que se suponía previamente. Se estima que un cerebro adulto tiene alrededor de 100 mil millones de neuronas y puede construir 100 billones de sinapsis.

El enfoque basado en la teoría de la información tiene en cuenta el ruido de las numerosas señales y células del cerebro, además de ofrecer una unidad discreta de información, un bit, para medir la cantidad de datos que puede almacenar cada sinapsis. Los especialistas creen que esta nueva técnica permitirá trabajar en distintas áreas del cerebro para precisar la plasticidad sináptica existente, identificando además como el envejecimiento o algunas enfermedades pueden reducir esta capacidad.

Referencia

Synaptic Information Storage Capacity Measured With Information Theory. Terrence J. Sejnowski, Mohammad Samavat et al. Neural Computation (2024). DOI:https://doi.org/10.1162/neco_a_01659

- El párroco a la cuidadora: “Si te insinúan que lo envenenaste, di que le dabas la medicación que decían y punto”

- Llega la DANA a Valencia con alerta de granizo: las zonas donde habrá tormentas y lluvias explosivas

- Manu de Pasapalabra, condenado

- Se encuentra una cartera llena de dinero en Alboraia y la entrega a la Policía Local

- Daniel Sancho ya sabe cuál es su condena: sólo 450 euros

- Un millar de personas da su último adiós al vecino de Gata David Lledó

- Nuevo golpe para Ortega Cano: su hijo, José Fernando, investigado por un delito de estafa

- Intervienen en Xàtiva una furgoneta de reparto con alimentos mal conservados